IA e Información Pública

Hoy se utiliza la Inteligencia Artificial (IA) en muchos procesos de toma de decisión en el Estado, es de esperar que no lleguemos muy tarde con la necesaria regulación de su uso …

Hoy en día el uso de técnicas avanzadas en gestión de datos (inteligencia artificial, big data, aprendizaje automático) para su posterior uso en procesos automatizados de decisión se está masificando en diversos sectores, y si bien esto partió en ciertas industrias (retail, banca, seguros, marketing), hoy lo vemos en muchos sectores.

El aprendizaje automático es una forma de lograr la inteligencia artificial basada en la «capacidad de aprender sin estar explícitamente programado» mediante el «entrenamiento de un algoritmo para que pueda aprender», este proceso de “aprendizaje” se realiza utilizando grandes cantidades de datos por parte del algoritmo y permitiendo que éste se ajuste a sí mismo.

Uso en el Sector Público

El Sector Público no ha estado exento de esta tendencia, y desde hace ya un tiempo que se está utilizando en diferentes procesos, algunos ejemplos de ello:

- Sistemas de selección

- Asignación de beneficios

- Salud

- Fiscalización (tributaria, aduanera, mercados, etc.) entre otros

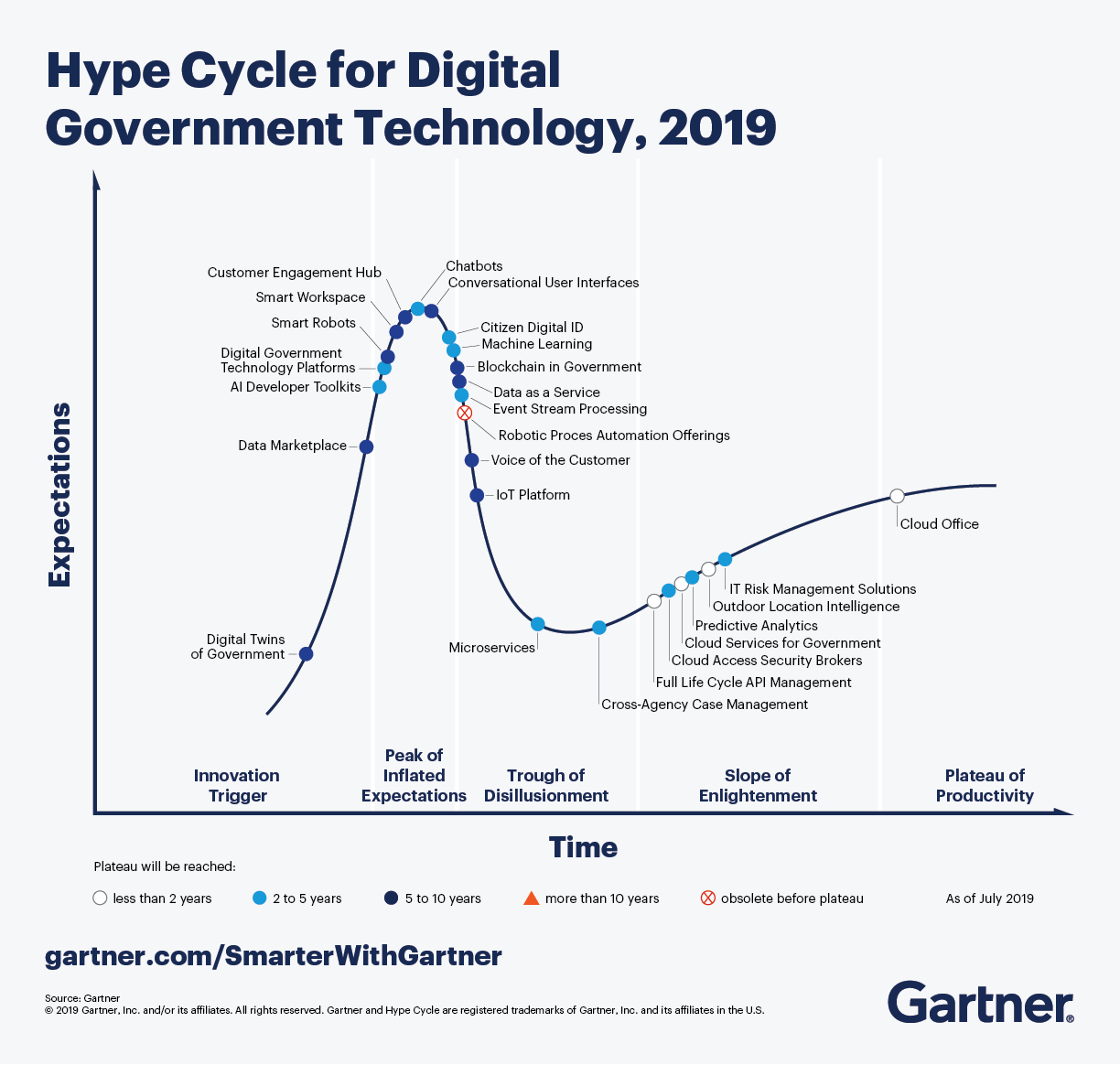

Las técnicas de aprendizaje de máquina (ML) e encuentran en el punto más alto, como lo muestra la curva hype de Gartner para Gobierno Digital.

Estos sistemas no están libre de problemas, incluyendo: sesgos, falta de transparencia, discriminación, estigmatización y falta de trazabilidad. Incluso hemos visto casos que han mostrado todas sus falencias y costos tanto políticos como sociales. Probablemente el ejemplo más reciente es el del gobierno holandés y su sistema de asignación de beneficios a familias vulnerables.

Desafíos para el Estado

El uso de las tecnologías vinculadas a la Inteligencia Artificial (IA) y el Aprendizaje de Máquina (ML) requieren de un importante esfuerzo normativo y operacional por parte del Estado. Muchos países han desarrollado políticas nacionales, y hoy en día se encuentran en un proceso de diseño de esas políticas.

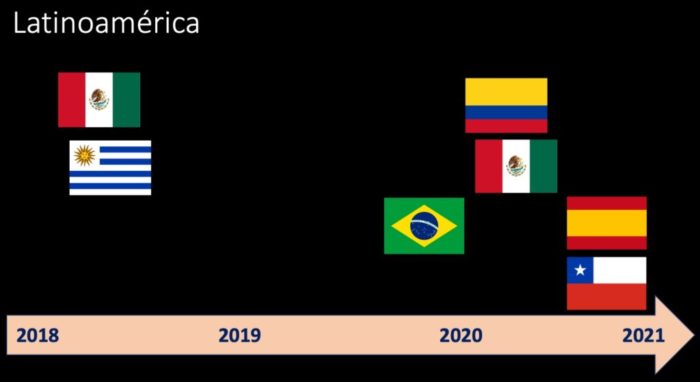

Esta gráfica tomada de la ponencia de Ricardo Baeza en el XII Encuentro Sociedad y Tecnologías de la Información. “El Impacto de la Inteligencia Artificial”, muestra en una línea de tiempo, las diferentes iniciativas de los países de la región en materias de políticas públicas en Inteligencia Artificial. Algunos comentarios al respecto: i) Argentina tuvo una iniciativa en 2019, pero esta fue descontinuada por el nuevo gobierno, es por eso que no aparece, ii) En el caso de México no es exactamente estrategia nacional, iii) La iniciativa de Uruguay está centrada fundamentalmente en el sector gobierno y iv) Colombia se centró en los temas éticos.

Los principales desafíos en este ámbito dicen relación con el uso ético de datos, y marcos regulatorios que den cuenta del nuevo escenario.

Ya lo he mencionado anteriormente, nuestros marcos normativos de acceso a la información pública no dan cuenta de estos avances tecnológicos, y ellos se sustentan en leyes de acceso, cuyo objeto de regulación son esencialmente documentos. Nuestro desafío hoy en día, es incorporar a esos marcos y políticas públicas, datos y algoritmos cómo objetos a ser regulados.

En el caso de los algoritmos y modelos, plantean una pregunta adicional, ya que existen dos formas de abordaje respecto de la transparencia algorítmica, me refiero a los conceptos de explicabilidad e interpretabilidad, les pido me perdonen el abuso del lenguaje.

Explicabilidad vs Interpretabilidad

Algunas preguntas que surgen es como debiéramos regular el acceso a la información de esos procesos automatizados de toma de decisión, esto es, debemos basarlos en modelo de Explicabilidad (Explicable Artificial Intelligence) o de Interpretabilidad (Interpretable Artificial Inteligence). Para mayores antecedentes de estos conceptos recomiendo el paper Beware explanations from AI health care y este artículo The dangers of trusting black-box machine learning.

IA Interpretable

Corresponde a modelos que en lugar de usar las denominadas cajas negras para sus algoritmos utilizan cajas blancas, es decir, permiten que sean entendibles en forma relativamente simple por una persona. Se trata de algoritmos entendibles y pueden ser descompuestos para su análisis posterior por una persona.

IA Explicable

Son algoritmos que utilizan modelos extremadamente complejos, ya sea por la cantidad de dimensiones (variables) que utilizan y/o las funciones matemáticas y estadísticas incorporadas y por lo tanto básicamente para el exterior funcionan como una caja negra. Para este caso, cuando se quiere dar acceso, se han adoptado técnicas de utilizar modelo aproximados (proxies) para su explicación, pero se debe tener claro que se trata de aproximaciones y que su comportamiento no es exactamente igual al modelo original.

Dados estos dos escenario, una pregunta que surge es en qué áreas se debiera utilizar una u otra técnica para efectos de las futuras normativas.

En este nuevo escenario, nuestras futuras regulaciones asociadas a sistemas automatizados de decisión, debieran considerar diferentes aspectos, y al menos incluir las siguientes exigencias a los servicios públicos:

- Inventario de los modelos y algoritmos con sus atributos

- Acceso a datos de entrenamiento

- Explicabilidad versus Interpretabilidad (cuándo aplicar uno u otro)

- Uso y procesos (replicación, trazabilidad)

- Mecanismos de apelación

¿Están nuestros diseñadores de políticas públicas y legisladores pensado los cambios que nuestros marcos normativos requieren?

Photo by Markus Spiske on Unsplash