Los seres humanos son más culpables que los robots

Si tienes dudas respecto de una situación en la cual están involucrados IA y personas, lo más probable es que sea un operador humano el primer «supuesto» culpable, los sistemas no fallan.

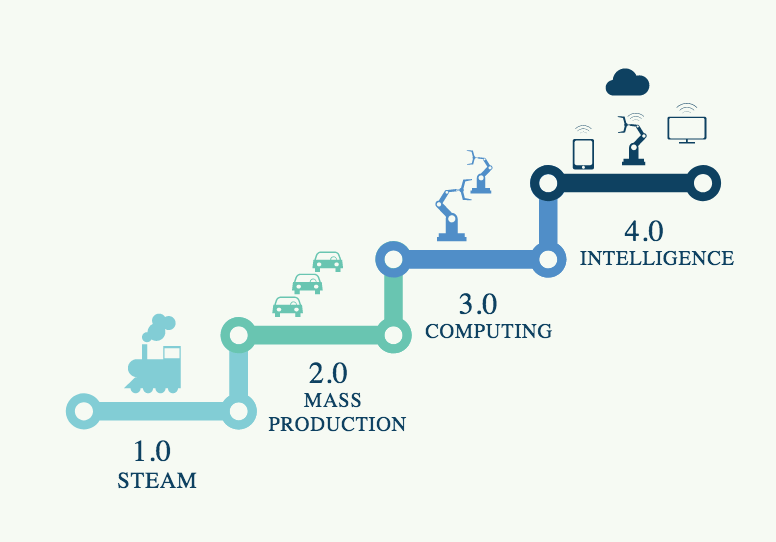

Hoy, producto de la revolución tecnológica, nos encontramos en un proceso creciente de automatización, el cual nos va a impactar en diversos aspectos de nuestra sociedad. Una de las áreas de mayor desarrollo es el de la inteligencia artificial, y su aplicación a diversos procesos (profesionales, industriales y sociales). En este ámbito, hay múltiples desafíos sobre los cuales aún no tenemos mayor claridad, en particular cuando se producen fallas de estos sistemas con algún grado de automatización.

La especialista, Madelaine Clare Elish, quien ha estudiado los aspectos asociados al impacto de las nuevas tecnologías en nuestra, plantea en un reciente paper, un interesante concepto denominado “zona de deformación moral” (moral crumple zone) haciendo un símil con el proceso de deformación que se produce en los vehículos a la hora de absorber el impacto producto de una colisión y que el conductor reciba el menor daño posible.

Ya hace unos años la misma Elish había escrito sobre lo mismo, Letting Autopilot Off the Hook – Why do we blame humans when automation fails?

Elish, atribuye este concepto a que en situaciones en las que están involucrados complejos sistemas automáticos y/o autónomos, y se produce una falla, la culpa será asignada a forma casi inmediata al ser humano más cerca del evento, es decir, el sesgo asociado a los «sistemas no fallan, serán preponderantes, esto es, el concepto de la zona de deformación moral la cual protege la integridad de los sistemas tecnológicos, en desmedro del operador humano más cercano. En muchos casos esa persona cercana tiene poca influencia en el comportamiento de ese sistema automatizado, por lo que incluso aunque pudiera tomar acciones éstas serán relativamente restringidas.

Lo anterior tiene un sesgo intrínseco, el cual ha sido planteando por algunos historiadores respecto de la tecnología, m refiero a, que existe la tendencia social a sobrestimar las capacidades de los sistemas y subestimar las capacidades de los seres humanos.

Elish, desarrolla su planteamiento a través de 3 ejemplos, algunos de ellos bastante antiguos

- Fallas en una central nuclear en los Estados Unidos en Three Mile Island, las cuales producto de un sistema de alerta poco entendible hizo que los operadores tomaran decisiones incorrectas.

- Vuelo Air France 447, que se estrelló en el Océano Atlántico, el cual por problemas de información y de su sistema de vuelo automático, atentó contra un buen desempeño de los pilotos, en momentos en los que se presentó una condición muy rara.

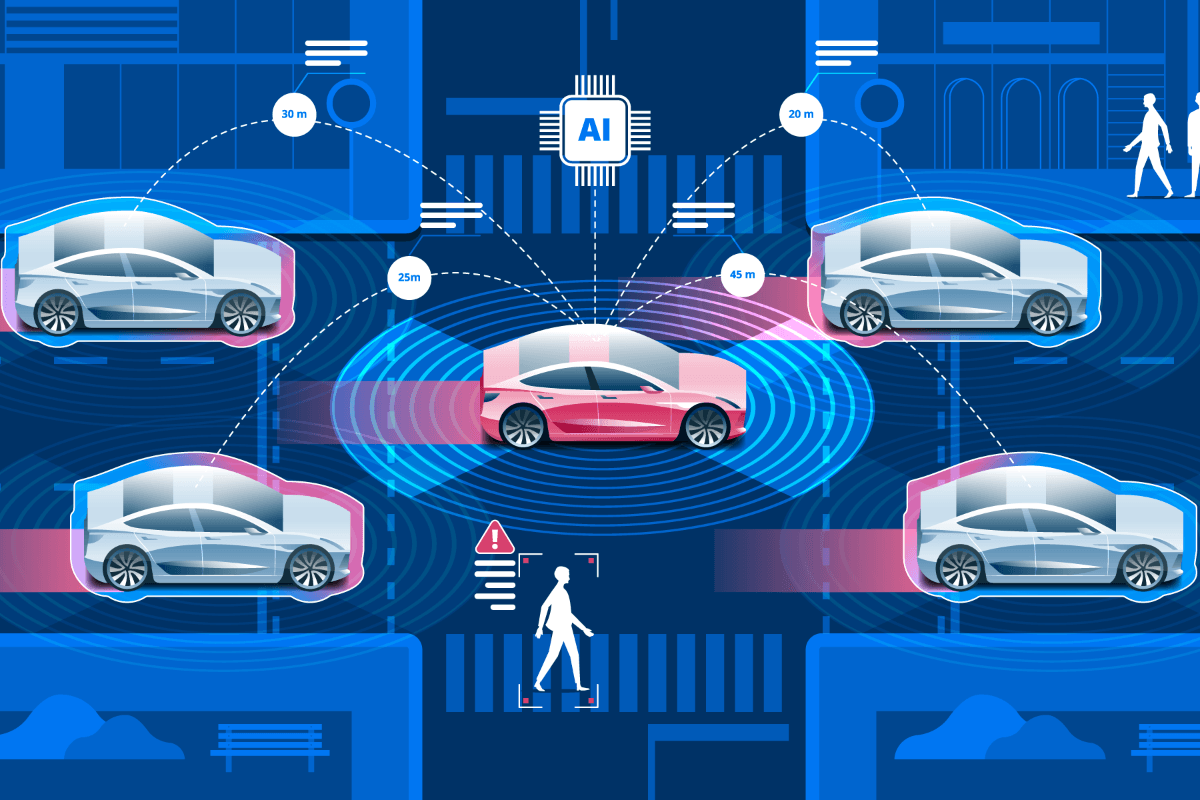

- Un Uber autónomo que atropelló a una persona en Arizona causándole finalmente la muerte, producto del accidente fue culpado el conductor de seguridad, que iba en el asiento del copiloto y no quienes desarrollaron el software del vehículo.

En estos 3 casos, aparece este efecto que llama Elish zona de deformación moral y en todos ellos los culpables iniciales fueron los seres humanos más cerca del evento. En ninguno de ellos, las culpas apuntaron a diseñadores/desarrolladores de dichos sistemas, sino al operador humano más cercano, esto es, vuelve a aparecer el sesgo de que la tecnología no tiene errores, y por el contrario el operador humano es el que se transforma en la parte que falla.

Esto, plantea una serie de desafíos a futuro en la medida que la automatización esté más presente en diferentes ámbitos. Lo que va a ser aún más complejo, cuando estemos en un proceso de transición, pensemos por un momento cuando tengamos ciudades con un porcentaje de vehículos autónomos, y el resto normales, a la hora de que se produzca un accidente, el análisis se realizará sin el “sesgo” de asumir que los vehículos autónomos son más seguros y por ende la culpa es de los conductores humanos.

Otro desafío, dice relación con el marco normativo y regulatorio, para aquellos participes en el diseño y construcción del sistema, ya que estamos hablando de muchas personas (cientos o miles en algunos casos), incluso en aquellos casos en que el sistema incorpore formas de aprendizaje, y por lo tanto se reconfigura en la la medida que cuenta con más datos, la culpabilidad original será algo difusa.