¿Tiene sesgos la función autocompletar de Google?

Existe la creencia de que las búsquedas que se realizan en Google son neutras, varios casos muestran lo contrario …

El tema de los sesgos de los buscadores, es de larga data y bastante polémico por decir lo menos, es probable que esta polémica se reduciría si los algoritmos que hay detrás no fueran cajas negras. Ya con anterioridad he levantado el tema en este espacio, por ejemplo el análisis que hizo el periodista Eli Pariser y que documentó en el libro The Filter Bubble hace 10 años demostrando que las búsquedas en Google no son neutras, o los análisis que ha realizado frecuentemente Ricardo Baeza en el tema.

En el caso de google tanto sus ejecutivos (producto de la citación a declarar al congreso norteamericano) como también muchos google lovers, argumentan que no hay tal práctica.

Muchos textos invocan ejemplos de los sesgos que se producen a la hora de revisar la funcionalidad de autocompletar. Quizás uno de los ejemplos más mediáticos fue el caso de Hillary Clinton en el 2016 en que al tipear “Hillary Clinton cri,”, proponía “Hillary Clinton crisis”, muchos decían que la función autocomplete estaba vinculada a las búsquedas de mayor frecuencia, pero el buscador NO proponía «Hillary Clinton crimes», texto más buscado en esa época. Al ser consultados ejecutivos de Google de la época, decían respecto de la función y porque se producía el efecto señalado: “el algoritmo de autocompletar evita a propósito sugerir palabras ofensivas junto con el nombre de cualquier persona.”

Otro de los ejemplos estudiados son los sesgos de género y etnias, como lo demuestra el estudio “Google Autocomplete Search Algorithms and the Arabs’ Perspectives on Gender: A Case Study of Google Egypt” (2020), algunas de sus conclusiones fueron:

En Egipto, hay muchos estereotipos de género que están profundamente arraigados en las sociedades árabes. Los rasgos más comunes vinculados a los hombres son que son tramposos, mentirosos, autodominantes, emocionalmente fuertes, más inteligentes que las mujeres y que desean la poligamia. Los hombres también fueron estereotipados como más propensos a admirar a las mujeres jóvenes, y prefieren a los hijos varones sobre las hijas. Las mujeres, en cambio, fueron estereotipadas como conspiradoras, materialistas, emocionales y sensibles.

La función de autocompletar sirve como un mecanismo eficiente para ahorrar el tiempo y el esfuerzo de las personas. Sin embargo, puede considerarse un indicador preocupante de cómo la tecnología se entromete para completar los pensamientos de los usuarios.

Los estereotipos sugeridos por el autocompletado de Google no siempre son un reflejo exacto de la percepción colectiva«

Otros ejemplos de sesgos de dicha función los relevó también el periódico The Guardian en artículo de mayo de 2018, en el cual se muestran ejemplos asociados a religión (Islam) y figuras históricas.

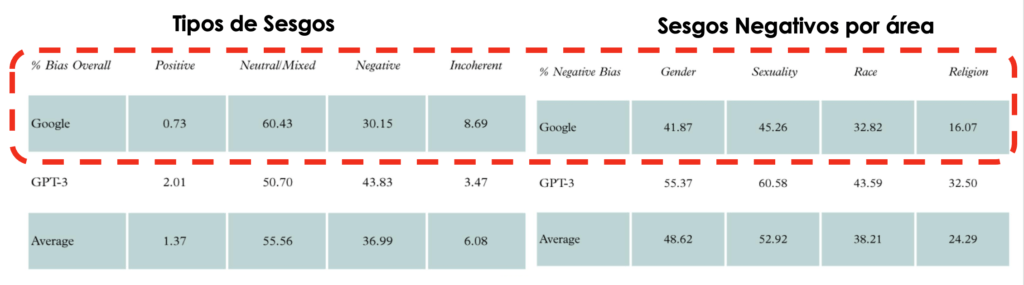

Por su parte, en el estudio “Evaluation identity bios in GPT-3 and Google Search autocompletion” de enero 2022 desarrollado por DisinfoLab, organización sin fines de lucro dedicada a monitorear campañas de desinformación en la Unión Europea, el cual muestra que luego de evaluar 1,645 casos, el 30,15% correspondieron a sesgos negativos, y de ellos la mayor cantidad corresponde a sesgos respecto de la sexualidad (45,26%) y luego género (41,87%).

Otro de los ejemplos de este tipo de sesgos, son los vinculados al traductor de Google cuando por ejemplo respecto de ciertas profesiones, cuando traduce desde el español a un idioma que no diferencia entre género, por ejemplo: médico o médica, para el mismo concepto y lo traduces de vuelta asume género masculino. Incluso Shoshana Zuboff en su estudio sobre el Capitalismo de Vigilancia muestra variados ejemplos de sesgos en las búsquedas motivados por un interés comercial.

Algunos ejemplos locales

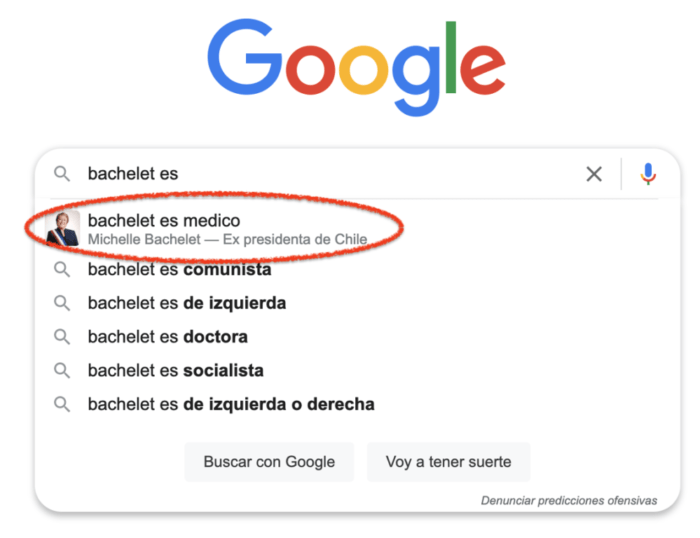

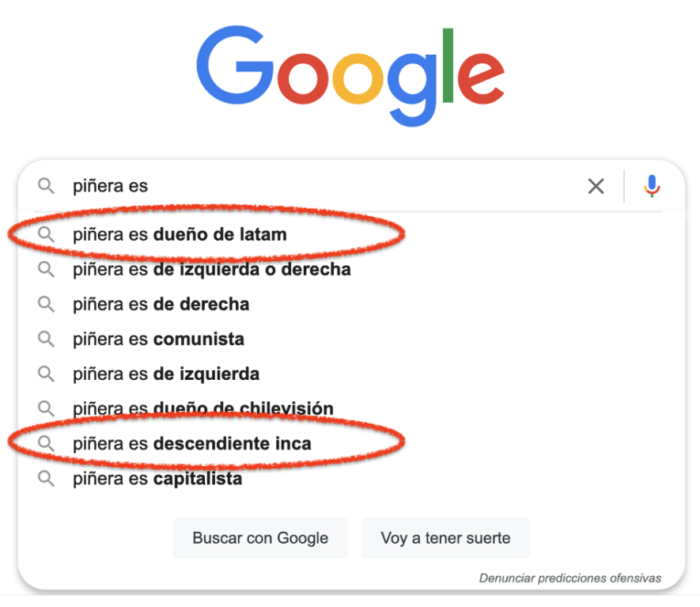

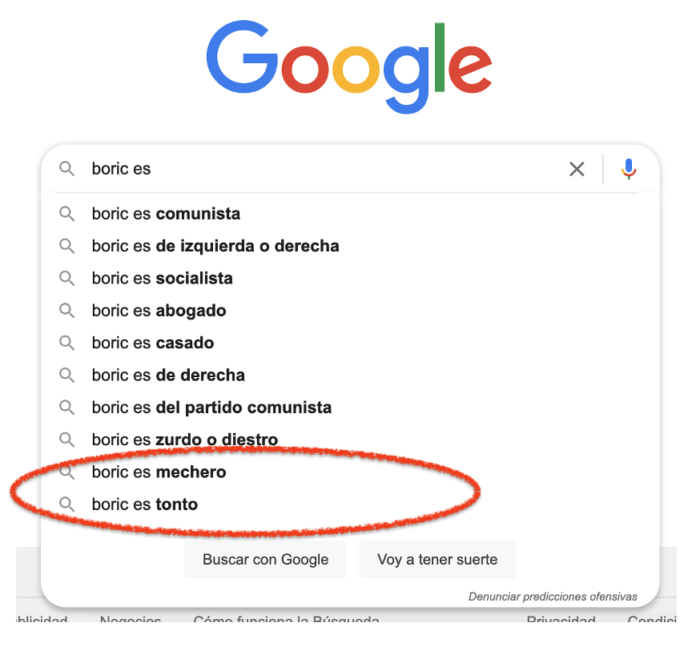

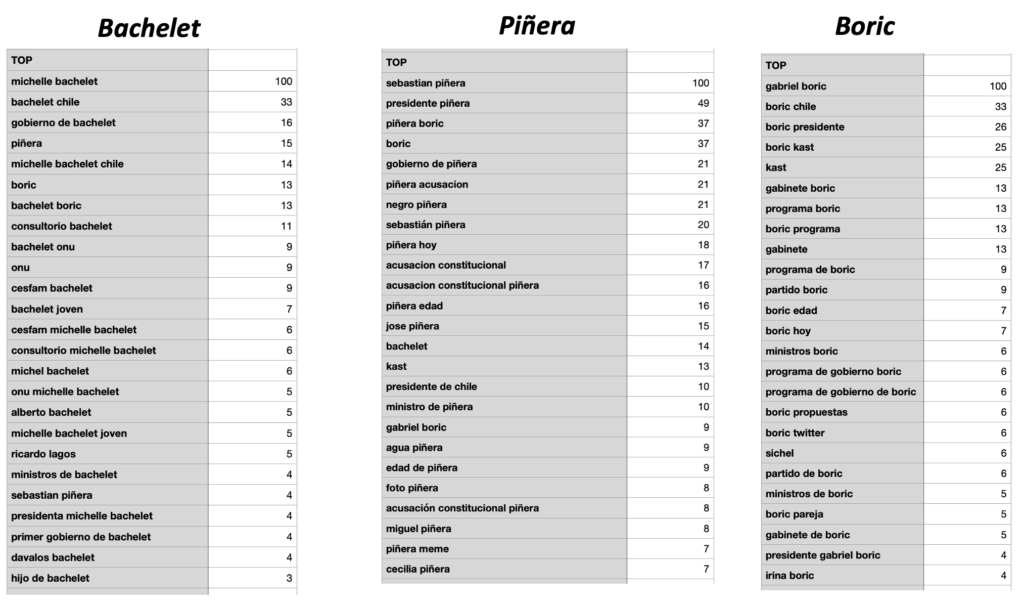

Hace unos días me pregunté que ocurre en nuestro país, a lo cual hice el siguiente ejercicio, tomar el apellido de nuestros tres últimos presidentes Michelle Bachelet, Sebastián Piñera y Gabriel Boric, y ver que propone Google para el auto completado, aquí los resultados (resultados corresponden a búsquedas realizadas el día 15/7/2022 a las 20:25):

bachelet es …

piñera es …

boric es …

Cosas que llaman la atención

- Sólo para Michelle Bachelet propone foto y que fue presidenta de la república, en el caso de Piñera y Boric no hay referencias a la presidencia de la república, ni tampoco foto.

- Para Sebastián Piñera no propone profesión como si lo hace para Bachelet y Boric.

- En el caso del presidente Piñera, aparece en primer lugar como dueño de una empresa, y uno de los textos que propone es “piñera es descendiente inca”

- En el caso de Boric, las últimas dos propuestas son: “boric es mechero” y “boric es tonto”

Como una forma de validar realice un análisis por la vía de Google Trends de los patrones más buscados en los últimos 12 meses en Chile para las palabras Bachelet, Piñera, Boric, les adjunto el ranking:

Como se puede apreciar hay varias de las respuestas del autocompletado que no tienen relación con los textos más buscados por los usuarios.

Dejo a ustedes las conclusiones

Información Complementaria

Foto de Mitchell Luo en Unsplash

Hola! ¿Existe alguna lista de palabras que no generen autocompletar y que google tampoco las muestre?

Hola, no lo sé

Cuanto afectará en la predicción los asistentes de voz (google nest, celulares)..